元学习(MetaLearning)或者叫做“学会学习”(Learningtolearn),它是要“学会如何学习”,即利用以往的知识经验来指导新任务的学习,具有学会学习的能力。

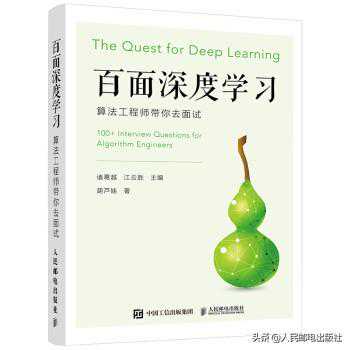

元学习的概念、主要方法以及模型等内容,在《百面深度学习》这本书的第7章给了我们较为详细的讲解,有兴趣的同学可进行阅读。

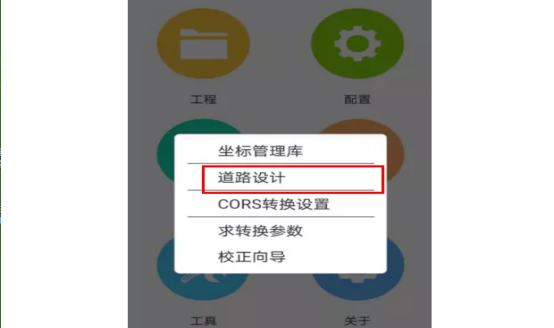

下面人邮君和大家一起来了解一下。

由于元学习可帮助模型在少量样本下快速学习,从元学习的使用角度看,人们也称之为少次学习(Few-ShotLearning)。

更具体地,如果训练样本数为1,则称为一次学习(One-ShotLearning);训练样本数为K,称为K次学习;更极端地,训练样本数为0,称为零次学习(Zero-ShotLearning)。另外,多任务学习(MultitaskLearning)和迁移学习(TransferLearning)在理论层面上都能归结到元学习的大家庭中。

当前的深度学习大部分情况下只能从头开始训练。使用Finetune来学习新任务,效果往往不好,而MetaLearning就是研究如何让神经元两个很好的利用以往的知识,使得能根据新任务的调整自己。

JürgenSchmidhuber[德],计算机科学家,以在人工智能、深度学习和人工神经网络领域的工作而著称

瑞士DalleMolle人工智能研究所的联合主任JürgenSchmidhuber在1987年毕业论文《Evolutionaryprinciplesinselfreferentiallearning.(Onlearninghowtolearn:Themeta-meta-hook.)》中最早提出了元学习的概念。在1992和1993两年里又借助循环神经网络进一步发展元学习方法。

元学习适合哪些学习场景?在人工智能系统的背景下,元学习可以简单地定义为获取知识多样性(knowledgeversatility)的能力。作为人类,我们能够以最少的信息同时快速完成多个任务;例如人类在有了世界的概念之后,看一张图片就能学会识别一种物体,而不需要向神经网络一样一切都得从头训练;又例如在学会了骑自行车之后,可以基本在很短时间里无障碍地学会骑电动车。

目前的AI系统擅长掌握单一技能,例如Go,Jeopardy甚至直升机特技飞行。但是,当你要求AI系统做各种简单但又略有不同的问题时,它会很困难。相比之下,人类可以智能地行动和适应各种新的情况。

元学习要解决的就是这样的问题:设计出拥有获取知识多样性能力的机器学习模型,它可以在基于过去的经验与知识下,通过少量的训练样本快速学会新概念和技能。

与多任务学习以及迁移学习看似相同其实不尽相同的元学习?元学习虽然从适应新任务的角度看,像是多任务学习;从利用过去信息的角度看,又像迁移学习。不过相对比二者还是有自己的特殊性

相较于迁移学习元学习模型的泛化不依赖于数据量。而迁移学习微调阶段还是需要大量的数据去喂模型的,不然会很影响最终效果。而元学习的逻辑是在新的任务上只用很少量的样本就可以完成学习,看一眼就可以学会。从这个角度看,迁移学习可以理解为元学习的一种效率较低的实现方式。

对比多任务学习元学习实现了无限制任务级别的泛化。因为元学习基于大量的同类任务(如图像分类任务)去学习到一个模型,这个模型可以有效泛化到所有图像分类任务上。

而多任务学习是基于多个不同的任务同时进行损失函数优化,它的学习范围只限定在这几个不同的任务里,并不具学习的特性。

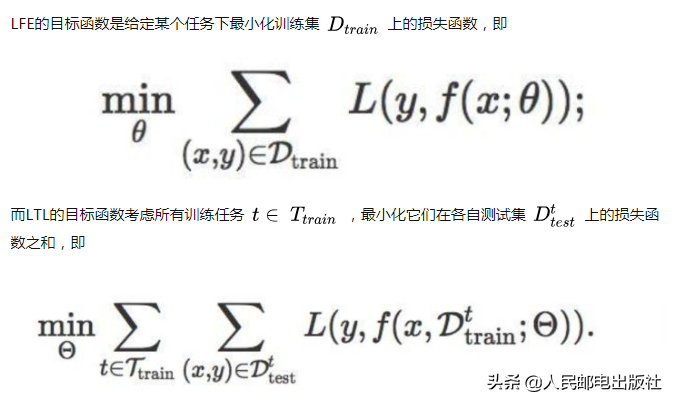

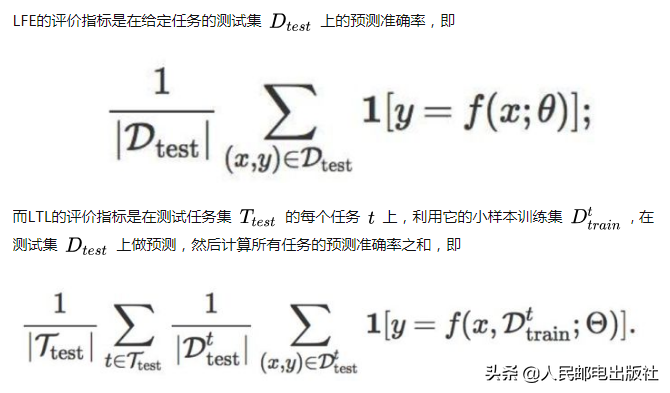

meta-learning与有监督学习强化学习具体有哪些差别?我们把有监督学习和强化学习称为从经验中学习(LearningfromExperiences),下面简称LFE;而把元学习称为学会学习(LearningtoLearn),下面简称LTL。两者的区别如下。

训练集不同

LFE的训练集面向一个任务,由大量的训练经验构成,每条训练经验即为有监督学习的(样本,标签)对,或者强化学习的回合(episode)而LTL的训练集是一个任务集合,其中的每个任务都各自带有自己的训练经验。

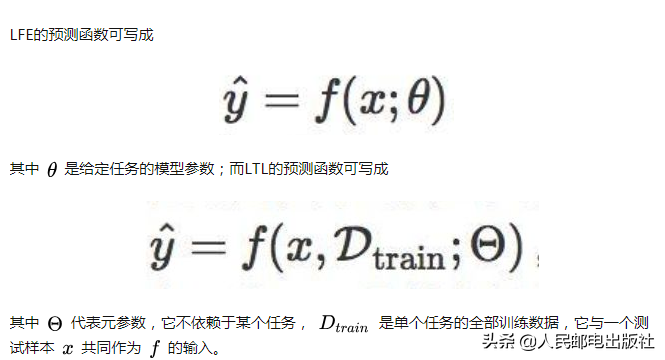

预测函数不同

损失函数不同

评价指标不同

学习内涵不同

LFE是基层面的学习,学习的是样本特征(或数据点)与标签之间呈现的相关关系,最终转化为学习一个带参函数的形式;而LTL是在基层面之上,元层面的学习,学习的是多个相似任务之间存在的共性。不同任务都有一个与自己适配的最优函数,因此LTL是在整个函数空间上做学习,要学习出这些最优函数遵循的共同属性。

泛化目标不同

LFE的泛化目标是从训练样本或已知样本出发,推广到测试样本或新样本;而LTL的泛化目标是从多个不同但相关的任务入手,推广到一个个新任务。LTL的泛化可以指导LFE的泛化,提升LFE在面对小样本任务时的泛化效率。

与其他任务的关系不同

————

更多关于元学习的内容,例如元学习的主要方法、数据准备、模型等,请见《百面深度学习》。

《百面深度学习》由Hulu的近30位算法研究员和算法工程师共同编写完成,专门针对深度学习领域,全面收录135道真实算法面试题,直击面试要点,是《百面机器学习:算法工程师带你去面试》的延伸。

《百面深度学习》仍然采用知识点问答的形式来组织内容,每个问题都给出了难度级和相关知识点,以督促读者进行自我检查和主动思考。书中每个章节精心筛选了对应领域的不同方面、不同层次上的问题,相互搭配,展示深度学习的“百面”精彩,让不同读者都能找到合适的内容。

:hover{text-decoration:none;}/*pc样式*/.pgc-card{box-sizing:border-box;height:164px;border:1pxsolide8e8e8;height:120px;position:absolute;right:76px;top:20px;}.pgc-cover{position:absolute;width:162px;height:162px;top:0;left:0;background-size:cover;}.pgc-content{overflow:hidden;position:relative;top:50%;-webkit-transform:translateY(-50%);transform:translateY(-50%);}.pgc-content-title{font-size:18px;color:444;overflow:hidden;text-overflow:ellipsis;padding-top:9px;overflow:hidden;line-height:1.2em;display:-webkit-inline-box;-webkit-line-clamp:2;-webkit-box-orient:vertical;}.pgc-content-price{font-size:22px;color:406599;font-size:14px;text-align:center;}.pgc-buy-text{padding-top:10px;}.pgc-icon-buy{height:23px;width:20px;display:inline-block;background:url();}百面深度学习算法工程师带你去面试

¥74.3

购买

元学习已经被大家研究了几十年,可我们对他的探索依旧方兴未已,各种神奇的想法层出不穷,但是真正的杀手级算法还未出现,未来元学习也将有更多的可能。